Журнальный клуб Интелрос » Финиковый Компот » №8, 2015

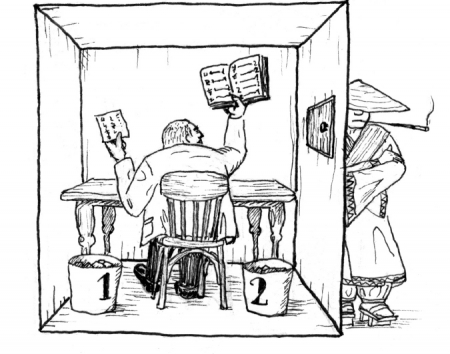

Сёрл придумал отличный мысленный эксперимент в ответ на тест Тьюринга. Интуиция понятна: даже если машина в состоянии пройти этот тест, совсем не очевидно, что машина будет обладать сознанием. Для иллюстрации этого и придумана «Китайская Комната» (КК). Большое число споров свелось к обсуждению последствий мысленного эксперимента, но я хочу обратить внимание на саму возможность существования Комнаты.

Сёрл придумал отличный мысленный эксперимент в ответ на тест Тьюринга. Интуиция понятна: даже если машина в состоянии пройти этот тест, совсем не очевидно, что машина будет обладать сознанием. Для иллюстрации этого и придумана «Китайская Комната» (КК). Большое число споров свелось к обсуждению последствий мысленного эксперимента, но я хочу обратить внимание на саму возможность существования Комнаты.

По условиям эксперимента, человек работает с книгой правил по обращению с иероглифами так, чтобы его собеседник был уверен в том, что он разговаривает с тем, кто в действительности знает китайский язык и понимает смысл вопросов. Возможно ли составить такую инструкцию? Иными словами, возможно ли описать язык конечным набором правил? На первый взгляд кажется очевидным, что достаточно сложный набор правил будет адекватно отражать структуру языка и создавать ощущение, что КК является сознательным собеседником. Для этого КК должна в первую очередь иметь возможность отвечать на поставленные вопросы. Если ответы будут устраивать собеседника, то он будет уверен в сознательности КК. Я не беру в счет «отписки» на каверзные вопросы и хочу рассмотреть, как по существу КК может отвечать на вопросы, не выдавая собеседнику «я не хочу об этом говорить» или «не знаю и знать не хочу». Для удобства все вопросы можно разделить на два основных типа: поясняющие и проблематические.

Вопросы первого типа могут быть такими: «когда началась Первая Мировая война?», «где находится Лондон?», «как изготавливают нержавеющую сталь?». Ответы на них будут однозначными вне зависимости от того, когда и при каких обстоятельствах они были спрошены. С подобными вопросами возможно построение алгоритма ответов: мы анализируем структуру вопроса, выявляем то, что в нём спрашивается, потом обращаемся к базе данных и находим необходимые сведения.

По-другому обстоят дела с проблематическими вопросами. Для примера можно взять такие вопросы: «в чем художественная ценность того или иного произведения искусства?», «почему Раскольников испытывал душевные терзания после убийства старушки?» и т.д. Можно задать вопрос и о пресловутой проблеме вагонетки: стоит ли спасать жизнь пятерых ценой жизни одного? Допустим, для ответа на первые два вопроса машина будет искать рецензии критиков, аналитику произведения, т.е. обращаться к «базе данных», как и в случае с поясняющими вопросами, но какими алгоритмами она будет пользоваться при поиске ответа на проблему вагонетки? Вполне возможно даже, что КК так или иначе сможет дать ответы на эти вопросы, но будут ли эти ответы удовлетворять того, кто их задаёт? Во всех подобных ответах предполагается «понимание» вопроса, исходя из которого может быть сформулирован ответ. Возможно ли алгоритмизировать все это?

Могу предположить, что на вопрос о вагонетке в инструкции будет содержаться два ответа: «я спасу пятерых и убью одного» и «я оставлю все как есть». А теперь главный вопрос к книге правил: что выбрать? Здесь мы имеем два варианта развития событий. Во-первых, в инструкции может заранее быть предпочтён один из вариантов отве та — не важно, так ли, что в ней будет прямо прописан единственный ответ конкретно на проблему вагонетки, или так, что выбор этого ответа будет являться лишь частным случаем следования общему алгоритму «между А и В выбор только А». Во-вторых, в инструкции может содержаться указание на то, чтобы находящийся в Комнате провел операцию выбора: например, бросил монетку, посмотрел на часы, в общем, совершил любое действие, которое отличается от «перейди к странице N и выпиши иероглиф q». Следствия в обоих случаях неутешительные.

В первом случае книга правил должна содержать ответы на абсолютно все проблематические вопросы. Если так, то КК будет всезнающим, а самое главное — непоколебимым собеседником, который не способен изменить свое поведение (в данном случае — ответы на вопросы). Еще один довод в пользу маловероятности такого способа реализации — возможность бесконечно уточнять один и тот же проблематический вопрос, например: «говорить неправду плохо?», «говорить неправду, которая приведет ко благу, плохо?», «говорить неправду, которая приведет ко благу, но сделает хуже кому-то, плохо?». То есть мы всегда сможем задать КК такой проблематический вопрос, который будет на одно уточнение больше, чем содержится в ее книге правил.

Во втором варианте развития событий мы редуцируем любые проблематические вопросы к процедуре: «если мы должны выбирать, то мы выбираем во всех случаях вариант W». Что получится в этом случае? При достаточно долгом «разговоре» с КК можно будет сделать вывод, что собеседник — не человек и на вопросы он отвечает, потому что так записано в книге правил.

Но допустим, процедура выбора записана в книге правил как «если да или нет, то брось монетку». Это даст определенную вариативность, и на вопрос «почему ты сделал такой выбор?» КК может ответить: «потому что я так решил в этой ситуации». Процедуру выбора можно усложнять до бесконечности, учитывая перекрестные связи слов друг с другом, но, так как это мысленный эксперимент, предположим что машина в каждом случае достаточно уточняет вопрос и редуцирует его к выбору между «да» и «нет» так, что создается впечатление «понимания» вопроса. И вот здесь кроется главный «подводный камень» КК. По условиям мысленного эксперимента, человек в Комнате работает только с книгой правил и иероглифы для ответов берёт только соотнося одни с другими.

Если же мы расширяем Китайскую Комнату до «книга правил и процедура подбрасывания монетки», то теряется главная интуиция эксперимента. Объясню подробнее: результатом эксперимента Сёрл считает тот факт, что он, совершенно не зная китайского, тем не менее мог на нем говорить, используя всего лишь достаточно сложную книгу правил. Тем самым иллюстрируется принципиальная возможность и прохождения теста Тьюринга. Однако существование процедуры выбора в добавление к книге правил привносит в Комнату именно то, что Сёрл старался избежать. «Агент», который совершает выбор, безусловно, тоже не знает китайского языка. Но что имеет значение — этот агент совершает определенный выбор. Логичным развитием модели с агентом является работа с «записью» всех его «решений», но это не меняет сути. Главное, что для создания машины, которая была бы способна пройти тест Тьюринга, необходим не только набор правил (каким бы полным он ни был), но и специальный «действующий агент».

К чему приводит такая модификация КК? С одной стороны, можно сказать о «привидении в машине» и возвращении «картезианского театра», от которой уважаемый Д. Деннет так старался нас избавить. Но можно взглянуть на это и с другой стороны. Вместо человека в КК можно поместить робота, который будет подбрасывать монетку, когда встретит в книге правил определенную команду. И вот здесь «miracle occures»: записывая все свои предыдущие «выборы» и имея возможность совершать новые, механизм будет полностью имитировать поведение чело века-агента, хотя реализовываться он будет без всякого сознания.

По условиям эксперимента, КК должна быть способна отвечать на оба типа вопросов: как на поясняющие, так и на проблематические. В противном случае рано или поздно собеседник поймет, что КК китайского языка не знает. Значит, либо КК невозможна (нет ни одного способа реализовать алгоритм поиска ответов на оба типа вопросов), либо она возможна только лишь при наличии «агента». Вывод напрашивается сам собой: даже если мы будет стараться реализовать человеческое (в данном случае — речевое) поведение максимально механистически, мы так или иначе придем к необходимости появления чего-то, что предполагает «самость». «Самость» будет присуща всей КК, а агент будет оставаться непонимающим. Мы получим систему, которая будет ссылаться на два типа данных: внешние (книга правил) и внутренние (учет результатов прошлых решений при ответе на новые проблематические вопросы). Автореферентность, способность к свободному выбору и максимальная пластичность в поведении служат основанием для приписывания сознания.

Другой вопрос — какие перспективы открываются в таком случае? Вполне возможно, что такая Комната будет обладать квалиа. Или она будет так хорошо притворяться, что мы поверим в то, что она ими обладает, как верим в квалиа других людей.