Журнальный клуб Интелрос » Финиковый Компот » №8, 2015

Единственным надёжным критерием наличия сознания является «разумное» речевое поведение. И мы можем создать такую Машину, которая будет безупречно имитировать речевое поведение разумного существа; такую, что её речевое поведение будет неотличимо от человеческого. Но это и будет означать, что такая Машина удовлетворяет критерию наличия сознания, то есть что такая Машина — разумна. Такова в общих грубых чертах позиция Сильного искусственного интеллекта.

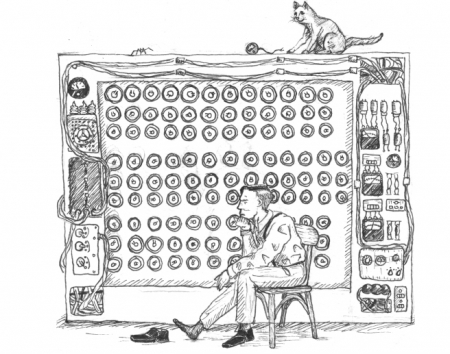

Единственным надёжным критерием наличия сознания является «разумное» речевое поведение. И мы можем создать такую Машину, которая будет безупречно имитировать речевое поведение разумного существа; такую, что её речевое поведение будет неотличимо от человеческого. Но это и будет означать, что такая Машина удовлетворяет критерию наличия сознания, то есть что такая Машина — разумна. Такова в общих грубых чертах позиция Сильного искусственного интеллекта.— Ах, как вы ошибаетесь! — восклицает Джон Сёрл. — Ведь наличие сознания предполагает наличие понимания! А о том, понимаю ли я нечто или нет, мне, как и любому разумному существу, известно непосредственно, а не в силу вашего критерия. И если допустить, что Машина, имитирующая речевое поведение человека (т.е. проходящая тест Тьюринга (ТТ)), обладает сознанием, то и я, в точности имитируя её работу, непосредственно выполняя её программу, должен буду обрести понимание. Но этого не произойдёт! Я решительно ничего не пойму, даже если очень буду стараться!

Условия действий Сёрла в Китайской Комнате (КК), надо полагать, известны. Но сможет ли он выполнить свою задачу? Ведь стоит нам лишь подобрать такие вопросы, на которые сможет ответить Машина, но не сможет Сёрл; или такие, на которые Сёрл не сможет ответить, не поняв значение хотя бы одного иероглифа, как мы разрушим КК! И таких вопросов немало.

Среди них в первую очередь достойны упоминания индексикальные вопросы и реплики (зависящие от конкретного контекста), среди которых удобно выделить 2 типа.

Вопросы о «мире». Который час? Где ближайший бар? Какая сегодня погода? Что идёт в Сатириконе?

Машина умеет отвечать на подобные вопросы лучше любого из ваших знакомых. Смысл каждого подобного вопроса или связанной с ним реплики (типа «Напиши мне вечером» или «Напомни мне снять бельё, если пойдет дождь») зависит от «контекста», задающегося конкретными внешними обстоятельствами, меняющимися со временем. Чтобы ориентироваться в нём, Машины обычно используют датчики, тем или иным образом связывающие их с внешним миром. Это может быть счетчик электрических колебаний кварцевого генератора, благодаря которому работает большинство электронных часов, датчик температуры воздуха или даже модем.

Сёрл не может позволить себе использовать датчики. Представим, что Сёрлу приходит какой-нибудь индексикальный вопрос о «мире» — например, «Который час?». Очевидно, что если Сёрл не будет уметь определять время, то не сможет и ориентироваться в нём, и тогда не только прямой вопрос, но и любая иная темпоральная реплика (типа «Напомни мне об этом завтра») позволит отличить его от мыслящего существа. Очевидно также, что прямой ответ на такой вопрос невозможно прописать в его инструкции. Допустить, что в КК стоят часы, и инструкция гласит, что, получив соответствующие китайские символы, Сёрл должен посмотреть на часы, переписать показания и отправить их в ответ, мы также не можем, поскольку в таком случае Сёрл точно поймёт, что значат соответствующие иероглиф-вопрос и его собственный ответ. Даже если такие часы вместо цифр будут показывать время «прописью» (иероглифами), их значение всё равно легко можно будет вычислить.

Но допустим, что мы замаскируем часы так, что Сёрл не сможет их распознать — скажем, под некую «коробочку» неясного предназначения с кнопкой, по нажатию которой будет распечатываться иероглифический ответ (текущее время). Нам, конечно, придется придумать ещё ряд каких-нибудь ограничений ad hoc (типа запрета Сёрлу пользоваться «коробочкой» без прямого указания инструкции — иначе он, опять же, сможет догадаться, что это часы; и т.п.), но даже если их допустить, возникнет вопрос: а кто, собственно, в таком случае продуцирует ответ? Становится очевидным, что ответ продуцируют сами часы, а роль Сёрла сводится к простому посредничеству, к передаче ответа от часов к вопрошающему. Даже если ответ «коробочки» будет зашифрован и его необходимо будет перевести, прежде чем послать в ответ, роль Сёрла окажется сильно редуцирована — в лучшем случае, он будет имитировать работу дисплея (переводящего некие непонятные, «зашифрованные» сигналы в узнаваемые нами символы), но никак не Машины в целом.

Часы мы привели лишь в виде частного примера устройства с датчиком — на их месте в «коробочке» мог бы быть термометр, ноутбук с доступом в интернет или Робот с технологией распознавания объектов. Ситуацию с последним разбирает В.В. Васильев, демонстрируя неэквивалентность КК и Китайского Робота. Васильев при этом подчеркивает, что если Сёрл, этот «не очень нужный помощник» Робота, не будет знать полностью его программу, это нарушит изначальные условия его задачи, а если будет знать, то обязательно разгадает значения некоторых иероглифов. Мы во многом согласны с Васильевым, однако в данном случае не можем придать принципиального значения «знанию». Нам кажется важным, что Сёрл должен самостоятельно исполнять эту программу — в противном случае бремя продуцирования ответа окажется с него снято, что лишит аргумент смысла.

Что может Сёрл, так это сымитировать работу Машины без датчиков. Пройдёт ли такая Машина ТТ? Васильев полагает, что Машина без датчиков не может рассматриваться даже как реализация проекта слабого ИИ. Мы в этом плане более оптимистичны и полагаем, что ТТ ей будет по силам. По крайней мере, с вопросом о времени она бы справилась (зная вычислительную скорость Машины, её саму можно превратить в своего рода «часы» — любой цикличный «фоновый» процесс можно превратить в хронометр). Доступно ей будет и знание погоды (в базу данных Машины можно загрузить прогнозы синоптиков, и первые несколько дней её ответы будут вполне удовлетворительными), расписаний, киноновинок, результатов текущих спортивных соревнований и иной информации, требуемой для индексикальных ответов. Понятно, что точность таких ответов будет падать с течением времени, но на первых — и достаточно продолжительных — порах её вполне будет хватать для приемлемых в рамках ТТ ответов. Тот довод, что Машина без датчика обязательно выдаст себя когда-нибудь — надо только дождаться, легко парируется. Сколько вам требуется времени, чтобы в условиях «живого» общения понять, что ваш собеседник разумен? Если же в условиях чата «судья» потребует для этого неделю, месяц или годы, резоннее будет поставить вопрос о разумности самого судьи, нежели его собеседника. Требование же точных и верных ответов, предполагающих конкретное сиюминутное восприятие (на вопросы типа «что вы видите перед собой?», «кончился ли дождь?» и т.п.), в рамках ТТ может быть и не адекватно: судье не обязательно будет известна локация собеседника (для переписки в чате она вообще не должна играть роль) — но тогда и возможности удостовериться в точности и верности таких ответов он будет лишен.

Очень похоже на то, что Сёрл может позволить себе имитацию Машины без датчика. По крайней мере, всё, что возможно внести в базу данных такой Машины (типа последних новостей и прогнозов), можно было бы учесть и в его инструкциях. Но сможет ли он следить за временем? Можно ли допустить дискретность совершаемых им операций? И можно ли будет рассчитать его вычислительную скорость? Что тогда будет уместно сделать «фоновым процессом»? Не возникнет ли у Сёрла в таком случае понимания собственных действий и своего ответа, когда тот будет запрошен? Неимение однозначных ответов на эти и многие другие вопросы не позволяет нам сделать вывод. Д.Б. Волков, например, утверждает, что Сёрл без датчика не сможет ориентироваться во времени. Интуитивно нам кажется это верным. Но, скажем, Е.В. Логинов полагает, что сможет. Мы не знаем, кто прав.

Что может Сёрл, в любом случае, так это ответить на вопрос «Который час?» — «Не знаю» или «Не ношу часов». Такой ответ можно прописать в «книге правил», и он будет удовлетворять требованиям ТТ. Не стоит забывать, что ответы в ТТ не обязательно должны быть точными и верными. Вот только если Сёрл будет увёртываться от каждой темпоральной реплики и от большинства индексикальных вопросов о «мире», он вскоре выдаст себя.

Вопросы о «диалоге». Контекст этого типа индексикальных вопросов задаётся непосредственно ведущимся диалогом, а ответы могут требовать некоторых операций с ним. Речь не только об употреблении разного рода местоимений, но и о метазамечаниях: «Мы с Костей играли в кости. Пришли гости, и Костя спрятал кости. Сколько раз я произнёс имя мальчика?»; «Сколько предложений было в предыдущей реплике?» и т.д. Человек обычно легко отвечает на подобные вопросы, особенно если они изложены в письменном виде.

Машина умеет отвечать на них лучше человека. Ваш текстовый редактор знает, сколько знаков с пробелами содержится в вашем документе, не говоря о предложениях, а программный поиск по ключевому слову давно не вызывает удивления. В этом отношении справляться с местоимениями Машине значительно сложнее, но и эта задача давно не выглядит невыполнимой. Отметим также, что в данном случае различия Машин с датчиком и Машин без датчика в принципе не прослеживается.

Сёрл не может позволить себе свободные операции с диалогом. Мы в принципе не представляем, как должна быть написана его инструкция, чтобы адекватно распознавать местоимения. Представьте, что КК говорит нам, что кто-то уже высказывал это возражение Сёрлу. «А он им на это что?» — спросим мы. Получим ли мы адекватный ответ?

Аналогично — с метазамечаниями. Что должно быть прописано в «книге правил», чтобы Сёрл ответил на вопрос про Костю? «Если вам пришел вопрос Сколько раз я произнёс Х, просмотрите поступившие вопросы, и если Х встречается в них 0 раз — отвечайте иероглифом Ноль; если 1 — Один; 2 — Два…» Нам кажется, примерно так можно запрограммировать Машину, но ведь это совершенно не годится для Сёрла — он обязательно поймёт значение своего ответа! Д.Б. Волков, высказывая это замечание, оговаривает возможность наличия в распоряжении Сёрла вариантов всех возможных разворачивающихся бесед, однако такое допущение представляется слишком сильным. Оно предполагает фактическое всезнание КК. Нет сомнений, что такая КК пригодилась бы человечеству, однако Сёрл, имитирующий работу Машины, не должен обладать информационными ресурсами, превосходящими имеющиеся в её распоряжении. Машина же легко справляется с такими вопросами, не обладая всезнанием.

Что может Сёрл, так это ответить «42» или «Да ну тебя! Я думал, мы за жизнь поговорим, а ты…». Т.е. парировать каким-нибудь универсальным ответом, ориентированным на смену темы. Разок-другой в рамках ТТ это может сработать, но стоит лишь повторить подобного рода вопросы или предварить первый из них фразой «Хочу удостовериться, что ты — не Машина. Ответь, пожалуйста…» — и человек, как и Машина, дадут верный ответ, но Сёрл — вряд ли.

Мы видим, что индексикальные вопросы и реплики могут представлять существенную проблему для Сёрла в КК, но их одних может оказаться недостаточно для диагностирования отличия КК от Машины. В таком случае на помощь приходят «редуктивные» методы. Их суть состоит в том, чтобы максимально упростить диалог и построить его так, чтобы Сёрл не мог не понять значения хотя бы некоторых «китайских» символов. Вот пара примеров.

«Языковые игры». Речь идёт не столько о витгенштейнианских играх, сколько об установлении определенных правил ведения диалога в духе игры. Можно, например, попросить собеседника отвечать вам только «да» и «нет», или самим начать использовать лишь односложные реплики. Диалог тогда будет подобен игре в съедобное-несъедобное, тем более что в китайском языке нет иероглифов, означающих «да» и «нет» — вместо них в ответе используется повтор глагола или его отрицания (например, «Ты любишь шоколад?» — «Люблю» — «А чеснок любишь?» — «Не люблю»).

Машина умеет играть в такую игру более чем непринужденно.

Но Сёрл не может позволить себе сыграть в неё — очень скоро по характеру использования символов он сможет определить, по крайней мере, значение иероглифа «не» и, скорее всего, заподозрит, что его ответы выражают утверждения и отрицания.

Что может Сёрл, так это, как водится, уклониться от этой игры, как и от множества ей подобных.

«Картинки». Вопросы и реплики с их использованием предполагают выражение основного смыслового содержания в наглядной графической форме. При этом иероглифы начинают играть существенно меньшую роль, и их значение становится легко узнаваемым. Такими наглядными элементами могут служить не только фотографии или рисунки, но и графические шрифты, дополнительные символы (геометрические фигуры, стрелки и т.п.), графика, созданная средствами стандартного шрифта (начиная фигурным строением текста (стихов), заканчивая смайлами) и т.п. Использование всех этих средств представляется возможным в рамках современного ТТ, проводимого в условиях чата (более того, в условиях чата возможно использование не только графического, но аудио- и видео-сопровождения и т.п.), а некоторых простейших из них — даже при коммуникации по телетайпу или морзянкой.

Машина умеет успешно работать со многими (пусть и не всеми) типами таких «картинок» и «интерпретировать» их должным образом. Не говоря о знаках и символах, «узнать» актёра по фотографии или «найти 10 отличий» не составит для неё особого труда.

Сёрл не может позволить себе работу ни с какими «картинками». В самом деле, много ли ему потребуется времени, чтобы разгадать, что значат иероглифы, например, в реплике «Я не Y!, яYöиÿ»? Аналогично и фразы о «10 различиях» будут во многом для него понятны.

Что может Сёрл, так это запретить использование таких «картинок». Он может сказать, что оно нарушает условие изначальной задачи, согласно которому узник КК не должен заранее знать значения ни одной используемой графемы или иного элемента, несущего смысловое содержание. Но тогда придётся запретить не только картинки, стрелочки или смайлы, но и любые знаки пунктуации, цифры, математические символы и даже те заранее неизвестные узнику знаки, о значении которых можно догадаться по их внешнему виду — как, например, знаки пиктографического письма, к которым, к слову, относятся и китайские иероглифы!

Все приведенные возражения кажутся убедительными. Действительно, в описанных условиях Сёрл не сможет сымитировать Машину, проходящую ТТ, не разгадав значения того или иного иероглифа. Можно сказать, что понимание Сёрлом значения некоторого символа не равносильно пониманию им китайского языка, но это возражение парируется напоминанием условий изначальной задачи: Сёрл обещал не понять решительно ничего, ни одной закорючки, а здесь он всё-таки что-то да понял, что, скорее всего, даст ему ключ и к пониманию иных иероглифов. В оправдание Сёрла можно было бы привести и более веский аргумент: понимание отдельных иероглифов возможно, однако оно не будет являться пониманием в силу исполняемости программы. Сёрл в КК может понять некоторые символы, но лишь потому, что имеет некоторый сторонний опыт: историю оперирования знаками естественного языка, представление о времени и т.п.

На это возражение, однако, находится ответ, гласящий, что именно так и строится обучение языку. Как ребёнок узнаёт значение слов «мяч» или «юла»? Так ли, что, впервые услышав их, он тем самым одновременно воспринимает и «заложенное» в них значение, или понимание строится на установлении условно-рефлекторной (ассоциативной) связи звука слова и присутствия в поле восприятия соответствующего элемента, который выделяется тем четче, чем чаще в различных контекстах этот звук воспринимается? Если допустить «мистический» первый случай, Сёрл должен будет понять значение иероглифов по одному их восприятию. Второй же случай аналогичен ситуации Сёрла — с тем лишь отличием, что общий, доступный обеим сторонам контекст дан Серлу не в непосредственном восприятии внешнего мира объектов, но его воспоминаниями. Если ребёнок со звуком «мяч» соотносит данные перцепции, то Сёрлу не с чем объективно соотносить знаки, которыми он оперирует, кроме как с данными памяти. Воспоминания служат для него тем, чем для ребёнка — вещи внешнего мира. Но если эти ситуации аналогичны, КК cможет научить китайскому языку, а это и будет означать провал сёрловского эксперимента! Более того, как кажется, не обнаруживается оснований, которые заставили бы нас отказать Машине в возможности построения связей (аналогичных ассоциативным) поступающих ей на «вход» символов с некоторыми данными памяти или даже, если она обладает датчиками, внешними объектами и факторами.

Наконец, в защиту Сёрла можно привести решающий аргумент. По условиям задачи, конкретно китайские иероглифы не имеют значения, принципиальным является лишь факт использования «непонятного набора знаков», а раз так, то суть КК не изменится, если вместо фраз на китайском Сёрл будет оперировать шифровкой. Но фразы естественного языка можно зашифровать так, что в отсутствие ключа разгадать их будет невозможно. Носителю такого «языка», т.е. носителю ключа дешифровки, ответы Сёрла будут казаться столь же разумными, что и китайцу — ответы классической КК. Но «редуктивные» методики в таком случае уже не сработают.

Более того, такая модификация КК, похоже, снимет и все индексикальные возражения. Так, в условиях использования поливариантности шифрования (если один иероглиф будет зашифровываться 10n способами), исключающей повторы последовательностей знаков, применения правил перестановки их последовательности или дополнения их «отвлекающими» бессмысленными символами, Сёрл не сможет установить значения ни одной из таких последовательностей, даже если инструкция будет содержать прямые указания на то, как следует отвечать на тот или иной вопрос о «диалоге» или о «мире», пусть даже требующий конкретного сенсорного восприятия. Он, очевидно, не сможет точно установить, что означает та или иная последовательность символов (скажем, что «90м» значит «стол»); не определит он и предмет разговора. Пред ставьте, что на вопрос «1Swa4 .h7vn 90м KLyw)n /fzж4@g15ъns цötu#…» Сёрл, согласно инструкции, должен посмотреть на свой стол, и, если на нём стоит банка Кока-Колы, ответить «пK3, =dёЩ>c 7&ь…». Он может, конечно, предположить, что речь в его ответе идёт о Кола-Коле, но с тем же успехом этот диалог может дешифроваться как «У вас есть в комнате стол?» — «Да». В условиях неповторяемости последовательностей знаков шифровки, у Сёрла не будет никакой возможности проверить своё предположение о предмете беседы, а инструкция, составленная с долей выдумки, может свести на нет вероятность его простого угадывания. Тем самым Сёрл сможет позволить себе даже имитацию машины с датчиками, задействуя вместо последних собственное восприятие, но останется обречён на непонимание.

Однако не совершим ли мы при допущении возможности шифрования принципиальной подмены естественного языка искусственным? Возможно, но тем больше это будет роднить КК с машинным вычислением. Машина оперирует не знаками естественного языка, но их кодировкой (в простейшем случае — в двоичном коде). Есть, конечно, разница между кодом и шифром, но в данном случае она уже не играет роли.

Что всё это значит? Мы показали, что существуют такие условия (условия оперирования знаками естественного языка), что Сёрл не сможет справиться со своей задачей, не обретя понимания. Если Сёрл позволит себе выполнить программу Машины, проходящей ТТ (и тем самым сымитировать её работу), он обязательно поймёт значение хотя бы некоторых знаков. А если он позволит себе остаться в неведении, то, не нарушая иных условий своей задачи (условия самостоятельного продуцирования ответа и т.п.), Сёрл проиграет игру в имитацию — мы сможем отличить его от Машины. Мы показали также, что существуют такие условия (с хитроумной шифровкой), в которых Сёрл сможет имитировать Машину, не обретая понимания.

Следует ли отсюда, что Сёрл не прав и КК проваливается в силу наличия таких условий, что её узник непременно обретёт понимание? Или, напротив, что Сёрл прав и Машина никогда не обретёт понимания в силу формальности своей программы, что подтверждается именно вариацией с шифровкой? Можно ли заключить, что прав Тьюринг и Машина сможет мыслить и понимать, стоит лишь создать соответствующие условия (скажем, подобрать должный язык программирования — аналог естественного языка для КК)? Или, быть может, что Тьюринг не прав и его критерий определения наличия сознания по речевому поведению не надёжен, поскольку допускает возможность прохождения ТТ без фактического наличия сознания и понимания у испытуемого?

Мы полагаем, что наше рассмотрение наглядно демонстрирует лишь то, что аргумент от имитации не является в должной степени релевантным. Из того, что Сёрл поймёт нечто или не поймёт ничего, мы не можем заключить, что и имитируемая Машина обретёт или не обретёт некоторое понимание. Но то же справедливо и применительно к самому ТТ: имитация Машиной речевого поведения человека не может служить надежным свидетельством ни в пользу её «разумности», ни в обратную сторону. Скорее, она выступает лишь косвенным признаком, намёком на возможность наличия разума, что может служить поводом для постановки вопроса о нём, но не даёт достаточных оснований для ответа на этот вопрос. Такой вывод побуждает к ревизии самого критерия наличия сознания и способов осуществления проверки на соответствие ему.